-

《人工智能》目录

-

前言

-

数据中心

-

理论知识

-

基本安装

-

基本知识

-

Transformer

-

脉冲神经网络 (SNN)

-

数据处理

-

声音处理

- FunASR:阿里的语音识别

- Kaldi:ASR,语音识别,可以训练声学模型

- 星辰语音识别开源大模型:中国电信,【超多方言】ASR

- 最难方言温州话被攻克!中国电信语音大模型支持30种方言

- 播放音频文件

- 让 Python 来帮你朗读网页吧

- 从零开始搭建一个语音对话机器人

- Seed-TTS:字节发布高性能高逼真语音合成框架

- ChatTTS:语音合成

- edge-tts:语音合成,调用的微软edge的在线语音合成服务

- pyttsx3:语音转换

- python实现TTS离线语音合成

- StyleTTS2:one-shot语音风格迁移和逼真语音转换的论文阅读和代码实战

- Matcha-TTS:语音合成,

- Bailing-TTS:巨人网络支持普通话和方言混说的TTS大模型

-

图像处理

-

视频处理

-

文字处理

-

多模处理

-

动态记忆和自我反思

-

论文精选

-

大模型LLM

-

AIAgent

- 新一代AI模型Claude 3:有大学生智商,全面超越GPT-4

- FastChat——一个用于训练、部署和评估基于大型语言模型的聊天机器人的开放平台

- 谷歌DeepMind推出新一代药物研发AI模型AlphaFold 3

- LangChain-Chatchat (原 Langchain-ChatGLM)

- MaxKB本地私有大模型部署

- YOLO v10视觉目标检测算法本地端部署

- Fay数字人框架 助理版

- 百度开源 / Senta - 情感分析旨

- Moshi:法国的ai研究者Kyutai推出开源实时语音多模态模型

- GraphRAG:微软开源 的下一代 RAG 技术

- Move AI 推出 Move API,实现 2D 视频转 3D 运动数据

- Cloudflare 推出一键阻止 AI 机器人的新工具

- 腾讯开源混元 Captioner 模型,优化文生图数据集生成

- 改变答题顺序会显著降低大模型准确率

- OpenDevin:卡内基梅隆大学教授创立 All Hands AI,推出开源 AI 软件代理 OpenDevin

- 漆远创立无限光年,获阿里投资进军可信大模型赛道

- 阿里发布 FunAudioLLM 开源项目,推出 SenseVoice 和 CosyVoice 两大语音模型

- 快手文生图大模型 Kolors 宣布开源

- 商汤科技发布 InternLM-XComposer2.5 视觉语言模型

- 穹彻智能推出具身大脑 Noematrix Brain,聚焦操作物理常识与行为决策

- 华中科技大学等团队推出 Holmes-VAD,实现视频异常检测与解释

- 可灵AI/Kling:快手视频生成大模型 可灵 AI Kling

- 彻底改变语言模型:全新架构TTT,ML模型代替RNN隐藏状态

- 新型TTT架构诞生,能否取代Transformer和Mamba成为最强大模型?

- DG4D/DreamGaussian4D:四维建模及运动控制模型

- CosyVoice:阿里的语音生成,支持多语言、音色和情感控制

- SenseVoice :阿里语音识别、语种识别、情感识别、声学事件分类或检测

- Seed-TTS:字节的的语音生成,太逼真太形象了

- Fish-Speech:开源的TTS项目,语音生成

- ollama:大模型运行平台,支持cpu运行大模型

- 当实时数字人遇上LLM

- CMD 下的基本指令

- 语音对话大模型:借助阿里的FunAudioLLM搭建语音对话模型

- CogVideo:智谱版Sora开源爆火,4090单卡运行,A6000可微调

-

功能模块

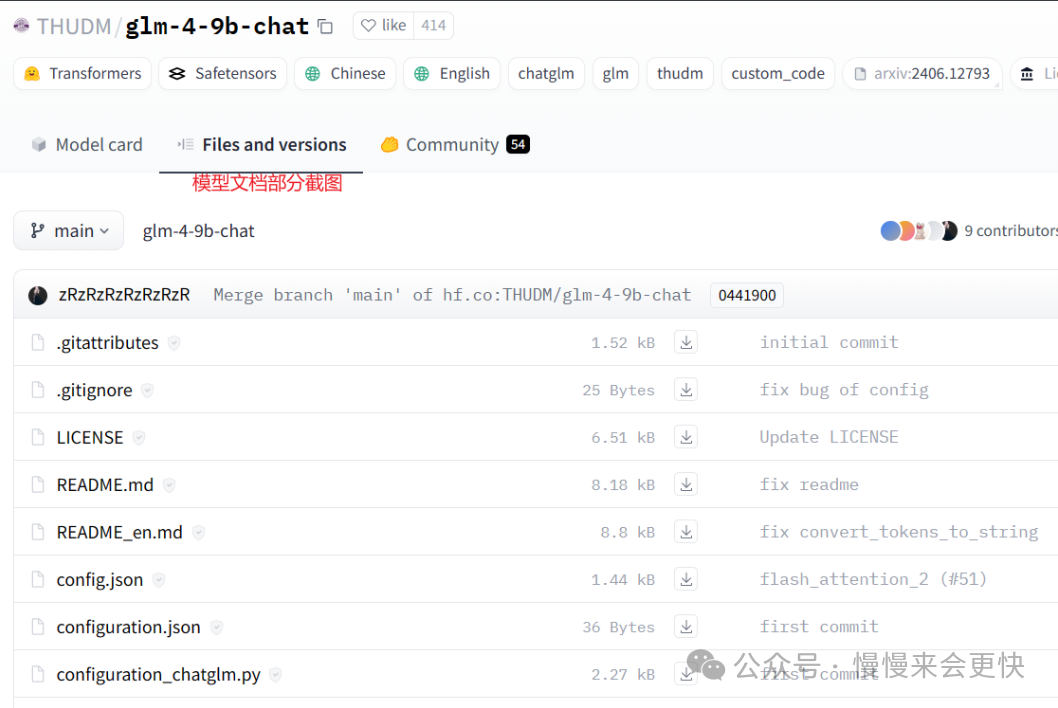

huggingface的模型文件的目录结构

正文

一、引言

随着人工智能技术的迅猛发展,大规模预训练模型(如GPT-4、BERT等)在自然语言处理、 图像识别等领域展现出了卓越的性能。然而,如何将这些强大的模型从理论落地到实际应用中, 仍然是许多技术从业者面临的挑战。本篇文章旨在为读者提供一份详尽的大模型落地指南, 从模型的下载、文件结构的解析,到本地化部署的具体步骤,全面覆盖整个流程。 无论你是初次接触大模型的新手,还是希望深入了解部署细节的资深开发者, 这篇文章都将为你提供有价值的参考和实用的操作指南。让我们一起揭开大模型神秘的面纱, 探索其在实际应用中的无限可能。

二、模型文件解析

模型文件下载地址:https://huggingface.co/models

本次课程以glm-4-9b-chat进行案例演示

1、下载模型文档

2、模型文档解释

在Hugging Face上下载的模型文件中,通常会包含很多不同类型的文件,每个文件都有其特定的作用。以下是一些常见的文件及其作用的解释:

gitattributes:

作用: 这个文件主要用于Git版本控制系统,用来定义特定文件的属性和处理方式。它可以指定文件的行尾符格式、合并策略、文件类型等。

config.json:

作用: 包含模型的配置参数,如模型架构、层数、隐藏单元数等。这个文件用于初始化模型的结构。

pytorch_model.bin:

作用: 这是PyTorch模型的权重文件,包含了模型的训练参数和权重数据。

tf_model.h5:

作用: 这是TensorFlow模型的权重文件,包含了模型的训练参数和权重数据。

tokenizer_config.json:

作用: 包含分词器的配置参数,如分词器类型、特殊标记等。

vocab.txt:

作用: 包含模型使用的词汇表,通常是一个简单的文本文件,每行一个词。

merges.txt:

作用: 如果使用的是Byte-Pair Encoding (BPE) 分词器,这个文件包含了分词合并规则。

special_tokens_map.json:

作用: 定义了特殊标记(如[CLS], [SEP], [MASK]等)的映射关系。

README.md:

作用: 包含模型的描述、使用方法和其他相关信息。

preprocessor_config.json:

作用: 包含预处理器的配置参数,用于数据预处理。

model-00001-of-xxxx.safetensors

文件名为model-00001-of-00010.safetensors的文件是模型权重文件的一部分。以下是关于这个文件的详细解释:

作用

分片存储: 这个文件是模型权重文件的一个分片,表示整个模型的权重被分成了多个部分存储。文件名中的00001-of-00010表示这是第1个分片,总共有10个分片。

高效存储和加载: 使用safetensors格式存储权重,目的是提高存储和加载的效率,同时保证数据的安全性和完整性。

存储内容

模型权重: 文件中存储的是神经网络模型的权重数据,这些数据是经过训练后得到的参数,用于模型的推理和预测。

数据格式: safetensors是一种高效的二进制格式,专门用于存储和加载深度学习模型的权重。相比于传统的bin或h5格式,safetensors格式在读取速度和安全性方面有一些优势。

使用方法

加载模型: 在加载模型时,框架(如PyTorch或TensorFlow)会自动识别并加载这些分片文件。通常你只需要提供模型配置文件(如config.json)和分词器配置文件(如tokenizer_config.json),框架会根据配置文件加载相应的权重分片。

这些文件共同作用,确保模型能够被正确加载、初始化和使用。具体的文件内容和作用可能会根据模型的类型和框架有所不同。

三、本地环境环境准备

在Linux环境下进行大模型的本地化部署,通常需要进行以下几个步骤来准备环境:

1. 更新系统

确保系统的所有软件包都是最新的,以避免兼容性问题。

sudo yum update1

2. 安装必要的依赖项

安装一些常见的依赖包,如编译器和工具链。

sudo yum groupinstall "Development Tools" sudo yum install wget12

3. 安装Miniconda

下载并安装Miniconda,这是一个轻量级的Conda版本。

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86\_64.sh bash Miniconda3-latest-Linux-x86\_64.sh12

按照提示完成安装,并重新启动终端或运行以下命令以激活Conda:

source ~/.bashrc1

4. 创建Conda虚拟环境

创建一个新的Conda虚拟环境,并激活它。

conda create --name myenv python=3.8 conda activate myenv12

5. 安装CUDA和cuDNN(可选)

如果需要使用GPU加速,可以通过Conda安装CUDA和cuDNN库。

conda install -c conda-forge cudatoolkit=11.2 cudnn=8.11

6. 安装深度学习框架

根据需要选择并安装深度学习框架,如TensorFlow或PyTorch。

\# 或者安装PyTorch conda install \-c pytorch torchvision12

7. 下载大模型

根据需要下载大模型的预训练权重文件。可以使用wget或curl命令下载模型文件、或者其他方式。

8. 安装其他必要的Python包

根据模型的需求,安装其他必要的Python包。

conda install numpy pandas conda install \-c conda-forge transformers12

9. 配置环境变量

根据需要配置环境变量,如CUDA路径等。

export PATH\=/usr/local/cuda/bin:$PATH export LD\_LIBRARY\_PATH\=/usr/local/cuda/lib64:$LD\_LIBRARY\_PATH12

10. 验证安装

运行简单的测试脚本,验证所有安装和配置是否正确。

import torch print(torch.cuda.is\_available()) \# 检查CUDA是否可用12

通过以上步骤,你的环境应该已经准备好进行大模型的本地化部署。根据具体的模型和应用要求,可能还需要进行一些额外的配置和调整。

四、本地化测试

from transformers import AutoTokenizer, AutoModel

tokenizer = AutoTokenizer.from\_pretrained("你的模型文件存储路径", trust\_remote\_code=True)

model = AutoModel.from\_pretrained("你的模型文件存储路径", trust\_remote\_code=True).cuda()

response, history = model.chat(tokenizer, "你好", history=\[\])

print(response)12345五、小结

本文详细介绍了大模型的本地化部署过程,从模型的下载到在Linux环境中的准备,再到简单的模型加载演示,提供了一条清晰的路径。